使用Docker + Ollama本地化部署大模型

前置要求

- 如果您已经满足上述要求,接下来我们将从Docker开始安装。

安装Docker

Docker安装完成后,我们可以使用以下命令来验证Docker是否安装成功:

1 | $ docker --version |

如果安装成功,你将看到类似以下的输出:

1 | Docker version 24.0.2, build cb74dfc |

- 在国内,由于网络原因,Docker官方的镜像源地址可能无法访问。因此,我们需要将镜像源地址换一换。

1 | vi /etc/docker/daemon.json |

随后将Docker重启

安装Ollama

- 拉取Ollama镜像

1 | $ docker pull ollama/ollama |

- 启动Ollama镜像

1 | $ docker run -d -p 11434:11434 ollama/ollama |

验证Ollama是否启动成功

可通过docker ps命令来查看Ollama是否启动成功。拉取大模型

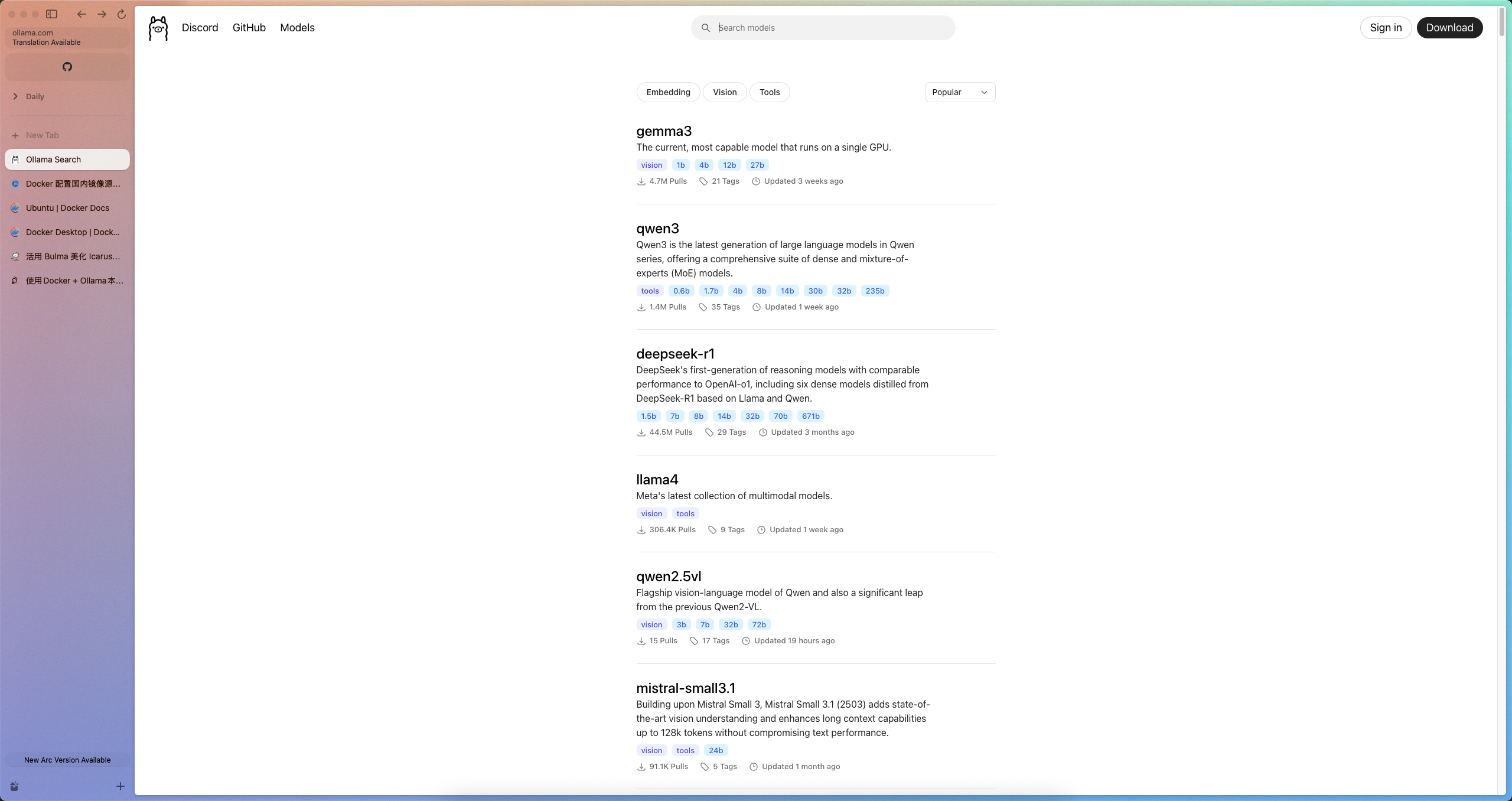

这里就以deepseek-r1:1.5b为例,我们可以通过以下命令来拉取模型:

1 | $ docker run -d -p 11434:11434 ollama/ollama run deepseek-r1:1.5b |

- 验证模型是否拉取成功

我们可以通过以下命令来验证模型是否拉取成功:

1 | $ docker exec -it ollama/ollama bash |

如果拉取成功,你将看到类似以下的输出:

1 | NAME MODEL CREATED STATUS |

至此,我们已经成功地使用Docker + Ollama本地化部署了大模型。之后我们将可以使用Dify或别的工具来调用或训练本地的大模型。

使用Docker + Ollama本地化部署大模型